「Open Agent Web」をうたうMicrosoftがBuildで発表 多様なツールの進化をアピール:MCPやA2Aに全面対応

Microsoftは年次イベント「Microsoft Build 2025」で、「Open Agent Web」というテーマを掲げた。どのような文脈でこの言葉を掲げているのか。同社はMCPやA2Aといったオープンプロトコルをサポートし、高機能なAIエージェントを高速かつ容易に作れる新機能を発表した。

この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

Microsoftが、2025年5月19日(米国時間)に開幕した年次イベント「Microsoft Build 2025」で、「Open Agent Web」というテーマを打ち出し、AIエージェントに関連するさまざまな発表を行った。

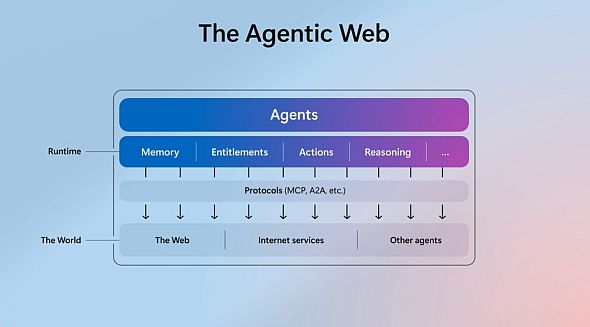

このキャッチフレーズは、AIエージェント同士がクモの巣のようにつながり合う世界を表現したものだという。また、同じく複雑な相互接続をイメージして名付けられた「World Wide Web」(Web)を意識している。AIエージェントは果てしないインパクトをもたらす技術。だが、普及させるには、Webのように誰もが有益なエージェントを容易に作れなければならない。これを助けるための多様なツールやサービスを、オープンな形で推進していくということのようだ。

Microsoft CTO(最高技術責任者)のケビン・スコット氏によると、生成AIモデルのリーズニング能力は過去1年で急速に進化した。しかし、そのペースにユースケースが全く追いついておらず、ギャップは広がるばかりだという。

このギャップを埋め、ますます複雑で高度な作業を生成AIシステムに任せられるようにするには、LLM(言語モデル)が能力を発揮できるよう、複数レイヤーにわたる環境を整えなければならない。例えばLLMのコンテキストウィンドウは拡大を続けてきたものの、複雑な問題の解決では、まだまだ記憶保持の課題が残る。LLMとのやり取りを記録して構造化し、これをRAG(検索拡張生成)に使ってより正確な応答ができるようにするなど、さまざまな工夫が必要という。

こうした環境を整えた上で、プロの開発者とビジネスパーソンの双方が、自分で発想し、自分で作れなければならない。業務ニーズに即した、時には複数のAIエージェントを活用する複雑なアプリケーションを、容易かつ高速に開発できる必要がある。

ここで重要になるのがオープン性だという。力のあるクラウド事業者などが、独自の技術で陣取り合戦をする時期は過ぎ去ったとスコット氏は話す。

「今重要なのは、どれだけ普及させることができるかだ」(スコット氏)

Webが成功した裏にはオープンな構造があった。同じようにAIエージェントを普及させるため、Microsoftは業界全体と力を合わせ、オープンな仕組みを推進していくとしている。

では、今回のイベントで、AIエージェントに関してどのような機能を発表したのか。主なものは以下の通り。

MCPとA2Aを広範にサポート

まず、Microsoftは、OpenAIとの提携関係を継続しながらも、生成AIモデルの選択肢を豊富に提供できることを強調した。

具体的には、AI/AIエージェント基盤「Azure AI Foundry」の「Azure AI Foundry Models」という機能を紹介した。Microsoftが自社や他社による1900種類以上のAIモデル(xAIの「Grok 3」や「Grok 3 mini」を含む)を統合的に提供し、料金は一括請求する。これにより、ユーザーは個々のAIエージェントのニーズに合わせてLLMを容易に選択し、利用できる。開発環境やデータ、ガバナンスを統合できるメリットがあるという。

Azure AI Foundry Modelsでは、各種ベンチマークに応じたAIモデルの順位表を示し、モデルの選択を支援する。タスクに応じて適したモデルをリアルタイムで自動選択する「Model Router」も発表した。

「オープン」という観点では、MCP(Model Context Protocol)、A2A(Agent2Agent Protocol)の2つのオープンプロトコルを広範にサポートしていくことを明確に宣言した。Semantic KernelとAutoGenは単一のSDKに統合するという。

MCPについては、「GitHub、Copilot Studio、Dynamics 365、Azure AI Foundry、Semantic Kernel、Windows 11を含むプラットフォーム全体で提供していく(発表ブログポスト)。加えて、MicrosoftとGitHubはMCPプロジェクト運営委員会のメンバーとなっており、認証仕様などについてコントリビューションをしているという。

A2Aについても、Azure AI Foundry、Copilot Studioから順次サポートしていくという。

Azure AI Foundry/Copilot Studio、GitHub、WindowsでAIエージェントを開発

Microsoftは今回、「Azure AI Foundry」「Copilot Studio」「GitHub」に加え、Windowsマシン上でローカルにAIアプリ開発ができる「Windows AI Foundry」

を発表。これら全てをAIエージェント開発の基盤として進化させていくという。

まず、「Azure AI Foundry Agent Service」 は一般提供の開始に伴い、複数のエージェントをオーケストレーションして複雑なタスクを処理できる機能が加わった。MCPとA2Aは、この機能に生かされている。

「Microsoft Copilot Studio」にも同様なオーケストレーションする機能が加わり、より複雑なタスクの開発に取り組めるようになった。

「Microsoft 365 Copilot Tuning」は、Microsoft 365サービス内の自社データでモデルをトレーニングできる機能。ローコードで高精度なAIエージェントを構築できるという。

GitHubは「GitHub Copilot Coding Agent」のパブリックプレビュー版を発表した。

IssueをCopilotに割り当てると、リポジトリを分析し、複数ファイルにわたるコード変更を行い、検証して、レビュー用にPull Requestをプッシュする。Coding Agentによる作業は逐一トラッキングでき、Pull Requestは必ず人間の承認を受けるようになっているため、誤ったコードがデプロイされるのを防げるという。

「十分にテストされたコードベースにおける、低から中程度の複雑さのタスク、例えば新機能の追加、バグ修正、リファクタリング、ドキュメント改善などに適している」(発表ブログポスト)

Coding Agentでは、リポジトリの設定でMCPサーバを設定できる。これにより、GitHub外のデータやツールを活用できるという。

セキュリティの観点では、「Microsoft Entra Agent ID」も注目される。Microsoft Copilot StudioやAzure AI Foundryで作成されたエージェントに一意のEntra IDが自動で割り当てられ、セキュリティ管理を強化できるという。

Copyright © ITmedia, Inc. All Rights Reserved.