Microsoft、「Azure AI」の新機能を発表 RAGを使いやすくする「統合ベクトル化」とは?:MoE(混合専門家)モデルも追加

Microsoftは、AIプラットフォーム「Azure AI」の機能強化について発表した。小型の言語モデルであるPhiモデルファミリーの追加やAIソリューションの構築に役立つ新しい機能が使えるようになった。

Microsoftは2024年8月22日(米国時間)、AI(人工知能)プラットフォーム「Azure AI」の機能強化について発表した。言語モデル「Phi」ファミリーでは新モデルを追加し、AIソリューションの構築に役立つ新しい機能が使えるようになった。

新言語モデルや生成AIサービスなど提供開始 新機能の概要

- PhiファミリーではMixture of Experts(MoE:混合専門家)モデル「Phi-3.5-MoE」などを投入した。Phiは、20以上の言語に対応した

- Azure AIサービスでAI21 Labsの「Jamba 1.5 Large」と「Jamba 1.5」が利用可能になった

- ベクトル化機能がAzure AI Searchに統合され、データ前処理が不要になり、RAG(Retrieval-Augmented Generation)パイプラインを容易に構築できるようになった

- 「Azure AI Document Intelligence」にカスタム生成抽出モデルが追加され、非構造化ドキュメントのカスタムフィールドを高い精度で抽出できるようになった

- 「Azure AI Speech」で自然な音声と写実的なアバターを作成できるサービス「Text to Speech (TT)Avatar」の一般提供を開始した

- 「Azure Machine Learning」用の「Visual Studio Code」拡張機能の一般提供を開始した

- 「Azure AI Language」では、会話テキストからプライベート情報を検出、マスキングする機能「Conversational PII Detection Service」の一般提供を開始した

Phiモデルファミリーの追加:対応言語増、高いスループットなど

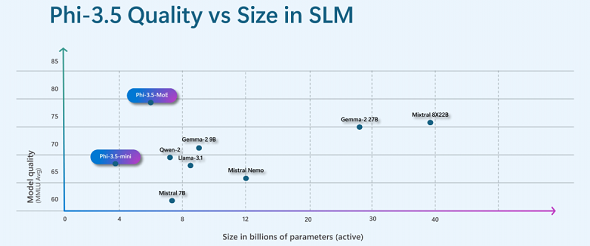

Phiファミリーに新モデル「Phi-3.5-MoE」が追加された。このモデルは420億のパラメーターを持っているが、訓練時にパラメーター(エキスパート)の一部を特化させ、実行時にはタスクに関連するエキスパートを使用することで、常時6.6Bのアクティブなパラメーターのみを使用する。16の小さなエキスパートを1つに統合し、モデルの品質向上と低遅延を実現している。このアプローチにより、小規模なモデルの高速性と計算効率性を享受しながら、大規模なモデルの領域知識と高品質な出力の利点が得られる。

また、同時にミニモデル「Phi-3.5-mini」も発表された。新しいMoEモデルとミニモデルはどちらも多言語対応で、20以上の言語をサポートしている。新しい言語が追加されても、「Phi-3.5-mini」は3.8億パラメーターの比較的小さいモデルだ。

Phiのビジョンモデルはマルチフレームに対応した。新モデル「Phi-3.5-vision」(42億パラメーター)は複数の入力画像に対して推論が可能となり、画像間の違いを特定するなどの新しい用途でも利用できるようになった。

Phiモデルを扱う開発者は、Azure AIの評価機能を使用して、組み込みまたはカスタムの指標を用いて品質と安全性を評価し、必要な対策を講じることができる。Azureのサービス「Azure AI Content Safety」で、プロンプトシールドや保護されたマテリアルの検出など、組み込みのコントロールと安全策を提供している。これらの機能はPhiを含むあらゆるモデルに対してコンテンツフィルターを通じて適用することも、単一のAPIで簡単にアプリケーションに統合することも可能だという。同社は、運用中、開発者はリアルタイムアラートを活用しながら、アプリケーションの品質や安全性、敵対的なプロンプト攻撃、データの整合性を監視し、タイムリーに介入できるとしている。

Azure AIモデルにAI21 Jamba 1.5 LargeおよびJamba 1.5を追加

AI21 Labsが開発したオープンモデル、Jamba 1.5 LargeとJamba 1.5がAzure AIモデルカタログに新しく追加された。これらのモデルはJambaアーキテクチャを使用しており、MambaとTransformerレイヤーを組み合わせて効率的に長文コンテキストを処理できるという。

AI21 Labsによると、Jamba 1.5 LargeとJamba 1.5はJambaシリーズの中で最も先進的なモデルだという。これらはハイブリッドMamba-Transformerアーキテクチャを採用しており、短距離依存関係にはMambaレイヤー、長距離依存関係にはTransformerレイヤーを用いることで、速度、メモリ、品質のバランスを保っている。その結果、このモデルファミリーは長いコンテキストの処理に優れており、金融サービス、ヘルスケア、ライフサイエンス、小売、CPG(消費財)などの業界に適しているという。

生成AIアプリケーション向けにRAGを簡素化

エンドツーエンドのデータの準備と埋め込みを統合し、RAGパイプラインの効率が上がった。組織は、生成AIアプリケーションでRAGを使用し、組織固有のプライベートデータに基づいた知識を取り入れ、モデルを再トレーニングしないで利用できる。RAGを使用すると、ベクトル検索やハイブリッド検索などの戦略を利用し、データに基づいた関連情報をクエリに応じて提供できる。しかし、ベクトル検索には、膨大なデータ準備が必要となる。アプリをCopilotで使用するには、複数のソースにまたがるさまざまな種類のデータを取り込み、解析、強化、埋め込み、インデックス化する必要がある。

2024年8月22日、Microsoftは併せてAzure AI Searchにおける統合ベクトル化の一般提供も発表した。統合ベクトル化により、これらのプロセスが全て1つのフローに自動化、効率化される。埋め込みモデルへの統合アクセスを使用した自動ベクトルインデックス作成とクエリにより、アプリケーションはデータの持つ潜在能力を最大限に引き出すことができるという。

統合ベクトル化は開発者の生産性向上に貢献するだけでなく、組織が新しいプロジェクトに対して迅速にターンキーのRAGシステムをソリューションとして提供できるようになる。そのため、チームが毎回カスタム展開を構築することなく、特定のデータセットやニーズに合わせたアプリケーションを素早く構築できるという。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

GitHub、数クリックで話題の生成AIモデルを試せる「GitHub Models」を発表

GitHub、数クリックで話題の生成AIモデルを試せる「GitHub Models」を発表

GitHubはAIアプリ開発支援サービスの「GitHub Models」を発表した。Microsoft、OpenAI、Meta、Mistralなどの人気のあるプライベートモデルやオープンモデルを数回のクリックとキー操作で実験、比較、テストできるという。 Microsoft、小規模言語モデル「Phi-3」公開 大規模言語モデルと異なる利用シーンを想定

Microsoft、小規模言語モデル「Phi-3」公開 大規模言語モデルと異なる利用シーンを想定

Microsoftは、自社開発の小規模言語モデル(SLM)ファミリー、「Phi-3」を発表した。シリーズ最小のパラメーター数の「Phi-3-mini」を公開し、Microsoft Azure AI Studio、Hugging Face、Ollamaで利用可能になった。 Microsoft Research、小規模言語モデル(SLM)の「Phi-2」を発表 MITライセンスで商用利用も可能

Microsoft Research、小規模言語モデル(SLM)の「Phi-2」を発表 MITライセンスで商用利用も可能

Microsoft Researchは、小規模言語モデル(SLM)の「Phi-2」を発表した。27億パラメーターを持つ言語モデルだが、最大25倍の大規模言語モデルに匹敵する性能を持つとしている。