AIを活用して脳から直接「声」を生み出す革新技術とは? カリフォルニア大学が長年の課題を解決:AIと脳神経科学の融合でリアルタイム音声合成が可能に

カリフォルニア大学バークレー校とサンフランシスコ校の研究者チームは、脳信号をほぼリアルタイムで可聴音声に合成する技術を開発した。これにより、重度のまひを持つ人々が自然な音声で発話できるようになるという。

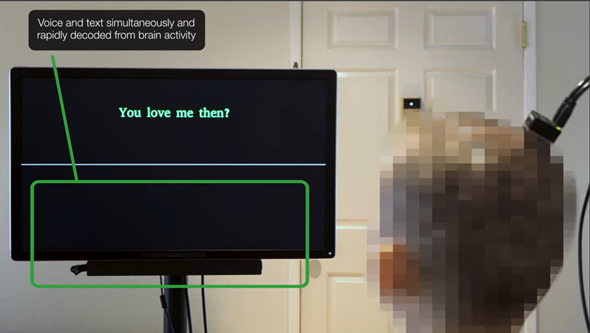

カリフォルニア大学バークレー校とサンフランシスコ校の研究者チームは2025年3月31日(米国時間)、脳信号をほぼリアルタイムで可聴音声に合成するストリーミング手法を開発したと発表した。同チームは以下のように紹介している。

この研究は、発話神経補綴(ほてつ)装置(失われた機能を補完する装置)において長年の課題であった「発話の試行」と「音声の生成」の間に生じるタイムラグ、すなわち遅延の問題を解決する。研究チームは、AI(人工知能)に基づくモデリング技術の近年の進歩を活用して、脳信号を可聴音声にほぼリアルタイムで変換するストリーミング方式を開発した。

神経データを音声に変換できるように

カリフォルニア大学バークレー校で電気工学とコンピュータサイエンスの博士課程に在籍する共同筆者チョル・ジュン・チョー氏によると、この神経補綴装置は、発話を制御する部分である脳の運動野から神経データをサンプリングし、その脳機能をAIが音声へとデコードする仕組みだという。

チョー氏は次のように述べている。「本質的には、思考が発声へと変換される過程、すなわち運動制御の途中にある信号を傍受する。つまりデコードしているのは、思考が完了し、話す内容が決まり、使う言葉や声道の筋肉の動かし方が決まった後の信号だ」

アルゴリズムの訓練に必要なデータを収集するため、研究者はまず被験者に、画面上に表示されたプロンプト(「ハーイ、元気?」のようなフレーズ)を見ながら、その文を心の中で話すように依頼した。

「これにより、彼女が生成する神経活動のチャンクウィンドウと、彼女が言おうとしているターゲット文との間でのマッピングが可能になり、彼女は一切発声する必要がなかった」と本研究の共同筆頭著者のケイロ・リトルジョン氏は述べている。

この被験者には発声能力が残っていないため、研究者たちは神経データ(入力)と対応させられる音声データ(出力)を得ることができなかった。彼らはAIで補うことにより、この課題を解決した。

チョー氏は次のように説明する。「私たちは、事前学習済みのテキスト読み上げモデルを用いて音声を生成し、目標出力をシミュレーションした。さらに、被験者の負傷前の声も使用したため、出力された音声は彼女自身の声により近いものとなっている」

音声のストリーミングをほぼリアルタイムで実現

以前のBCI(Brain Computer Interface:脳コンピュータインターフェース)研究では、音声を1文デコードするのに約8秒の遅延が発生していた。しかし、今回の新しいストリーミング手法では、被験者が発話を試みている最中に、ほぼリアルタイムで音声出力を生成できるようになった。

研究者たちは遅延を測定するために発話検出技術を用いて、発話開始を示す脳信号を特定できるようにした。

本研究の共同主任研究者であるゴパラ・アヌマンチパリ氏は次のように述べている。「意図信号に対して、1秒以内に最初の音声が出力されていることが確認できる。そして、この装置は継続的に音声をデコードできるため、被験者は途切れることなく話し続けることができる」

この高速化は、精度を犠牲にすることなく実現されている。より高速なインタフェースは、従来の非ストリーミング手法と同等の高いデコード精度を維持している。

「それが確認できたのは非常に有望だ」とリトルジョン氏は語る。「これまで、脳からリアルタイムで知覚可能な音声をストリーミングできるかどうかは未知数だった」

アヌマンチパリ氏は、大規模AIシステムが実際に学習、適応しているのか、それとも単に訓練データの一部をパターンマッチングして繰り返しているだけなのか、研究者は常に明確に分かるとは限らないと指摘する。そのため、研究者たちはリアルタイムモデルが訓練データセットに含まれていない「アルファ」や「ブラボー」「チャーリー」など、NATOの音声アルファベットから選ばれた26の希少語を合成できるかどうかを検証した。

「未知の単語にも一般化できるかどうか、そして被験者の発話パターンを本当にデコードできるのかどうかを確かめたかった」とアヌマンチパリ氏は語る。「結果として、私たちのモデルは課題をうまく実行できた。これは、音や声の構成要素を実際に学習していることを示している」

2023年の研究にも参加していたこの被験者は、今回の新しいストリーミング音声合成法と、以前のテキスト音声でコード方式との違いを研究者に語った。

「彼女は、ストリーミング音声合成の方がより意図的に制御できる手段であると伝えてくれた」とアヌマンチパリ氏は述べている。「自分自身の声をほぼリアルタイムで聴けることが、身体感覚の向上につながった」

今後の展望

今回の成果は、BCI装置による自然な発話の実現に一歩近づいたことを意味しており、今後のさらなる進展への基盤を築くものでもある。

「この概念実証的フレームワークは、非常に大きな前進だ」とチョー氏は述べている。「今後は、あらゆるレベルでの改善が期待できる。例えばエンジニアリングの面では、アルゴリズムの性能をさらに向上させ、より速く、より高品質な音声生成を目指していく」

さらに、研究者たちは、興奮しているときなど、会話中に起こるトーン、ピッチ、音量の変化を反映するために、出力音声に表現力を組み込むことにも引き続き注力していく。。

リトルジョン氏は次のように語っている。「脳活動からこうした準言語的特徴を、どれだけ正確にデコードできるかを探っている。これは、古典的な音声合成分野においても長年の課題であり、完全に自然な発話実現への架け橋となるだろう」

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

AIやロボットなど、Gartnerが2025年のサプライチェーン技術トレンド8つを発表

AIやロボットなど、Gartnerが2025年のサプライチェーン技術トレンド8つを発表

Gartnerは、2025年のサプライチェーン技術動向を発表した。拡張型コネクテッドワークフォースやマルチモーダルUIなど、8つの主要トレンドを挙げている。 OpenAI、音声エージェントを強化する新しい3つのモデルをAPIで提供開始 Whisperとは何が違う?

OpenAI、音声エージェントを強化する新しい3つのモデルをAPIで提供開始 Whisperとは何が違う?

OpenAIは、新しい音声認識モデル「gpt-4o-transcribe」と「gpt-4o-mini-transcribe」および音声合成モデル「gpt-4o-mini-tts」のAPIを提供開始した。 OpenAIが開発した音声生成モデル「Voice Engine」が見せた実力と課題

OpenAIが開発した音声生成モデル「Voice Engine」が見せた実力と課題

OpenAIは音声生成モデル「Voice Engine」の小規模プレビューから得られた予備的な知見と結果を公表した。このプレビューから合成音声生成の持つ可能性と課題が浮き彫りとなった。