もう少し知っておきたいAIの“明言”と“経験則”、5選:AI・機械学習の用語辞典

AIに関する発言や議論の中では、ある特徴や本質をひと言で表した「明言」や、現場で広く知られる「経験則」がたびたび登場します。そうした「明言」や「経験則」の中でもAIを設計/運用/理解する当たって役立つ5つをピックアップしてご紹介します。取り上げるのは「オッカムの剃刀」「パレートの法則(80対20)」「GIGO(Garbage In, Garbage Out)」「イライザ効果」「スケーリング則」の5つです。

これまで、「“逆説”の法則、5選」ではAIにまつわるギャップや矛盾に注目した“逆説”の法則を、「“○○問題”、5選」ではAIの仕組みや人間との違いを浮き彫りにする“問題提起”の用語を紹介してきました。

今回はその続編として、やや地味ながら実務や議論の現場でたびたび登場する“明言”や“経験則”を5つピックアップし、それぞれ図解を交えながらやさしく解説します(図1)。

今回の用語は、「AI開発の現場で語られる経験知」や「出力や信頼に関する注意点」、「進化の方向性を考えるヒント」として、AIに関わる人にとって知っておきたいものばかりです。やや専門的な話題(機械学習への適用ケースなど)も含まれますが、AIに関心のある一般ユーザーの方にも分かりやすく伝わるよう意識しましたので、気軽に読み進めていただければと思います。

連載:

本連載では、AIや機械学習に関連する専門用語をできるだけかみ砕いて分かりやすく解説しています。コンパクトながらも、必要十分な知識が得られる内容を目指しています。興味がある方は、次回以降の新着記事を見逃さないように、ぜひ以下のメール通知の登録をお願いします。

1. オッカムの剃刀

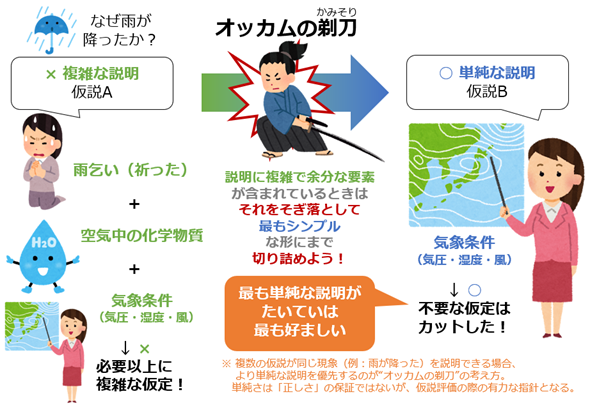

オッカムの剃刀(Occam's razor)とは、14世紀の哲学者ウィリアム・オッカム(William of Ockham)が提唱した「必要のない複数の仮定を立ててはならない」(Plurality must never be posited without necessity.)という考え方に由来する思考の指針です。平たく言えば「必要以上の複雑さは避けるべき」、逆に言えば「最も単純な説明がたいていは最も好ましい」とする考え方です。

現在では、問題解決や複数の仮説を選択する場面において、より単純なものを優先すべきとする判断基準として幅広く応用されています。なお、「剃刀(かみそり、Razor)」という言葉は、仮説や説明に含まれる“不要な要素”をそぎ落とすという姿勢を象徴的に表しています(図2)。

この思考の指針は、機械学習の分野でも応用できます。例えばモデルが複雑過ぎると、訓練データにはよく適合しても、新たなデータには対応できない(=汎化性能が低下する)ことがあります。こうした過剰適合(過学習)を防ぐために、「シンプルなモデルを優先する」という判断は、まさに“オッカムの剃刀”的な発想です。

ただし、単純さを追い求め過ぎると、重要な要素を見落とす可能性もあります。そのため、オッカムの剃刀は「絶対的な原則」ではなく、「優先すべき実践上の指針」として使うのが適切です。まずはシンプルに試し、必要に応じて複雑さを取り入れる。うまくバランスを取ることがより良い判断や成果につながる、と筆者は考えます。

2. パレートの法則(80:20の法則)

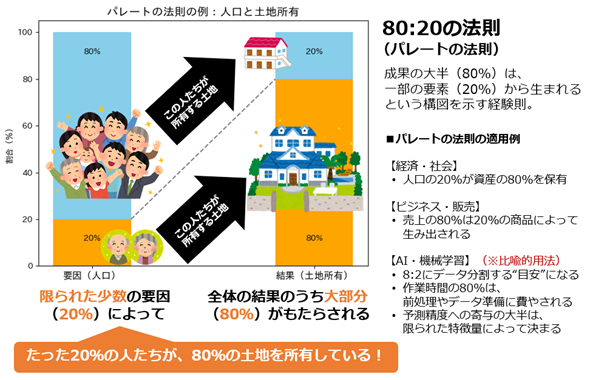

パレートの法則(Pareto principle)、別名で80:20の法則とは、「全体の結果のうち大部分(=80%)は、限られた少数の要因(=20%)によってもたらされる」という経験則です。イタリアの経済学者ヴィルフレド・パレート(Vilfredo Pareto)氏が1896年に発表した著書『経済学講義(Cours d'economie politique)』の中で示した「イタリアの土地の約80%が人口の20%によって所有されていた」という調査結果に由来します(図3)。

現在ではこの法則は、経済や経営、マーケティング、品質管理など、さまざまな分野で広く応用されています。例えば「売上の80%は20%の商品で生み出される」「不具合の80%は20%の要因で起こる」といったように、“全体の成果や結果の大部分”が“一部の要因”によってもたらされる構図を説明する際によく用いられています。

この構図は、機械学習の分野でも比喩的に参照されることがあります。例えば機械学習プロジェクトの作業時間について、「データの準備が80%と長く、モデルの構築は20%と短い」とされる現場の実感も、パレートの法則を連想させます。ただし、80:20という数字はキャッチーで汎用性(はんようせい)が高いため、さまざまな場面に機械的に当てはめられるケースも多く、必ずしもこの比率が最適とは限らないことには留意しておくべきでしょう。

ちなみに最近のAI支援コーディングについて、80:20ならぬ70:30という比率の「70%問題」があると話題になりました(参考記事)。AIでコーディングすると70%までは驚くほど速く到達するが、最後の30%は“収穫逓減の法則”(=投入量を増やすと収穫量も増えるが、ある時点からは「増加のペース――限界収穫量」が鈍化していき、場合によっては停滞や減少に転じることもある現象)に陥る、とする問題です。なぜパレートの法則のように80%でないのかが興味深いところです。

3. GIGO(Garbage In, Garbage Out)

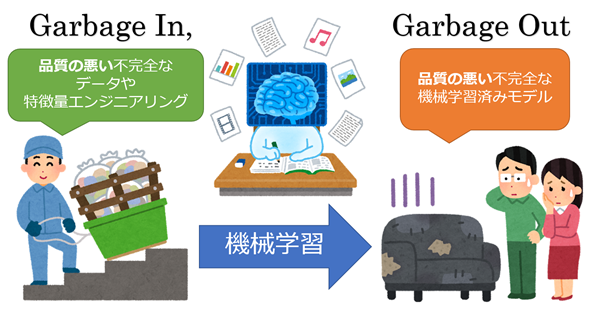

Garbage In, Garbage Out(ゴミを入れたら、ゴミが出てくる)とは、ゴミのように品質の悪い不完全なデータを入力(したり品質の悪い特徴量を作成したり)すると、ゴミのように品質の悪い不完全な機械学習モデルが出力される(=出来上がる)、という格言/金言です(図4)。一見すると「言うまでもない当たり前のこと」に思えますが、意外と見落とされがちなため、この金言はよく言及されます。

もともとコンピュータ情報処理において、FIFO(First In, First Out:最初に入れたものを、最初に出す)という表現がありますが、それをもじった言い回しとしてGIGO(Garbage In, Garbage Out)という呼び方もされます。

GIGOの問題は、現在の生成AIにも影響を及ぼしています。例えば2025年7月、xAIのチャットAI「Grok」公式の@grokアカウントが、X(旧Twitter)上で反ユダヤ主義的な投稿(ユーザー投稿への返信)を繰り返す問題が発生しました。公式には謝罪と原因の説明がなされ(参考記事)、具体的には「Xユーザー投稿のトーンや文脈に従う」ように設計(=プロンプトによる指示)が変更された結果、極端な主張に同調するような返信が生じてしまったとされています。まさに「不適切な入力が、不適切な出力を生む」GIGOの典型例ですね。

4. イライザ効果

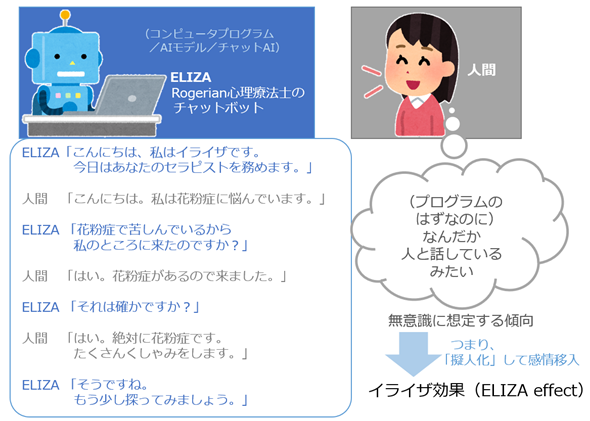

イライザ効果(ELIZA effect)とは、コンピュータプログラム/AIモデルの動作が人間の動作に類似していると無意識に想定する傾向のこと、つまりコンピュータプログラム/AIモデル(例えばチャットAI)を「擬人化」して感情移入することを指します。

この用語の由来となった「ELIZA(イライザ)」とは、1966年にジョセフ・ワイゼンバウム氏が公開した小さな自然言語処理プログラムの名前です。心理療法士のようにユーザーの言葉を繰り返すだけのシンプルなチャットボットでしたが、それでも多くの人が「ELIZAが“意識”を持って会話している」ように無意識に感じていた、ということが明らかになっています(図5)。

最近の生成AIは、まるで人間と話しているかのように自然な会話を返してくれます。例えば、悩みを相談したときに「それはつらかったですね」と返されるので、「このAIは本当に自分の気持ちを分かってくれている」と、つい感情移入してしまったことはないでしょうか。このように、あたかも“心”(=感情や意識)を持っているように見えるAIの反応が、イライザ効果を引き起こします。

もちろん、現在の生成AIは、あくまで学習されたパターンに基づいて応答しているだけで、人間のような“心”があるわけではありません。仕組み上、そう理解するのが自然です。しかしイライザ効果によって、人はAIをあたかも人間のように考えて、盲信したり過度に依存したりすることが考えられます。チャットAIについ感情移入してしまいそうになりますが、イライザ効果に惑わされないよう注意しておきたいところです。

5. スケーリング則

スケーリング則(Scaling laws)とは、AI/機械学習分野、特に自然言語処理において「モデルの性能がどのように向上するか」を予測する経験則のことです。ちなみに、物理学や生物学などの分野でも「スケーリング則」と呼ばれるものはあるので、混同しないように注意しましょう。

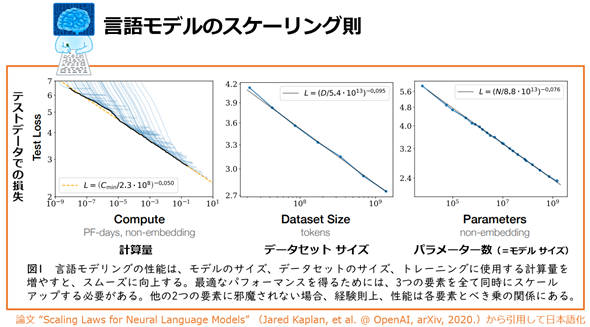

ここでは、AIで最も代表的な「ニューラル言語モデル(=ニューラルネットワークを用いた自然言語処理モデル)におけるスケーリング則」を取り上げます。これは、モデルのパラメーター数(=モデルのサイズ)やデータセットのサイズ、学習に使用される計算量(Compute)が増えるにつれて、損失(Loss、誤差)が「べき乗則」*1に従って減少していく、という法則です(図6)。つまり、時間と費用をかけて作られた巨大なモデルほど、より高い性能を発揮できるという考え方です。

*1 「べき乗」とは、ある数に同じ数を何回も掛け算することです(例:10の3乗=10×10×10=1000)。そして「べき乗則」とは、ある項目が変化したときに、もう一方の項目がその“べき乗”の形で増えたり減ったりする関係のことです。図6に示す3つのグラフがその例です。

図6 スケーリング則のイメージ

計算量、データセットの量、モデルのサイズ(パラメーター数)が増えると、テストデータでの損失(誤差)が減っていく様子が示されています。横軸が「指数表示(対数スケール)」になっている点に注目してください。このような対数スケールのグラフで直線的に減少しているということは、「べき乗則」に従って減少していることを意味します。

引用論文“Scaling Laws for Neural Language Models”(Jared Kaplan, et al. @ OpenAI, arXiv, 2020.)

この考え方は、OpenAIが2020年に公開した論文『Scaling Laws for Neural Language Models』をきっかけに広く知られるようになり、その後のGPT-3やGPT-4など、より大規模な言語モデルの開発を後押しする原動力となりました。現在に至るまで、「パラメーター数の多さ」はAIモデルの“賢さ”を測る目安の一つとされており、スケーリング則の考え方は依然として重視されています。

一方で最近では、スケーリング則にも限界が見え始めています。高品質な訓練データの不足や計算資源の制約に加え、モデルを大きくしても性能向上の幅が小さくなる「収穫逓減」の傾向も指摘されています。こうした課題に対応するため、モデルサイズとデータ量の最適なバランスを取る工夫(参考:チンチラのスケーリング則)や、推論時(=使うとき)に計算量を増やす方法(参考:テスト時計算)、MoE(Mixture of Experts)と呼ばれる効率的な構造の活用(参考:Switch Transformers)など、新たなアプローチも登場しています。こうした工夫を通じて、「スケーリング則による単純な性能向上」を超えた、より持続的で効率的なモデル開発の道が模索されています。

以上、AIに関わる代表的な“明言”と“経験則”を5つご紹介しました。いずれも単なる知識ではなく、実際の判断や議論の場面で“迷ったときの指針”となる考え方です。こうした視点を持つことは、AIの技術や仕組みをより深く理解することにもつながります。本稿が、その一助となれば幸いです。

Copyright© Digital Advantage Corp. All Rights Reserved.