AIに関わる人が知っておくべき“○○問題”、5選:AI・機械学習の用語辞典

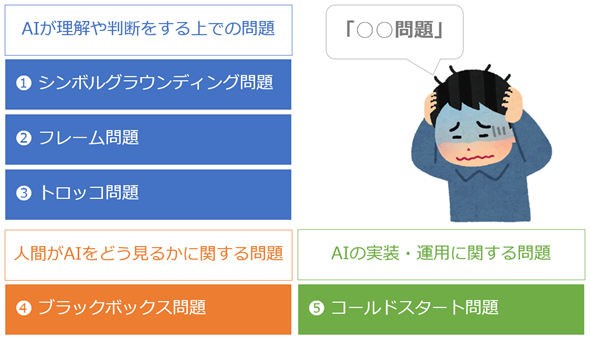

AIには、その仕組みや性能上の限界、人間とは根本的に異なる特性などを浮き彫りにする「○○問題」と呼ばれる用語が幾つかあります。その中でも特に代表的なものをピックアップしてご紹介します。取り上げるのは「シンボルグラウンディング問題」「フレーム問題」「トロッコ問題」「ブラックボックス問題」「コールドスタート問題」の5つです。

急速に進化するAIには、その仕組みや性能上の限界、人間との根本的な違いといった問題が今なお存在しています。それに加えて、倫理や社会への影響など、さまざまな側面から議論されてきた課題もあります。

それらはときに「○○問題」といった用語で表現されます。本稿では、その中から代表的なものを5つピックアップし、それぞれ図解を交えながらやさしく紹介します(図1)。

AIや機械学習にまだなじみがない方から、実務でAIに関わる方まで、視野を広げて理解を深めるきっかけとなる内容です。この機会に、ぜひ押さえておきましょう。

連載:

本連載では、AIや機械学習に関連する専門用語をできるだけかみ砕いて分かりやすく解説しています。コンパクトながらも、必要十分な知識が得られる内容を目指しています。興味がある方は、次回以降の新着記事を見逃さないように、ぜひ以下のメール通知の登録をお願いします。

1. シンボルグラウンディング問題

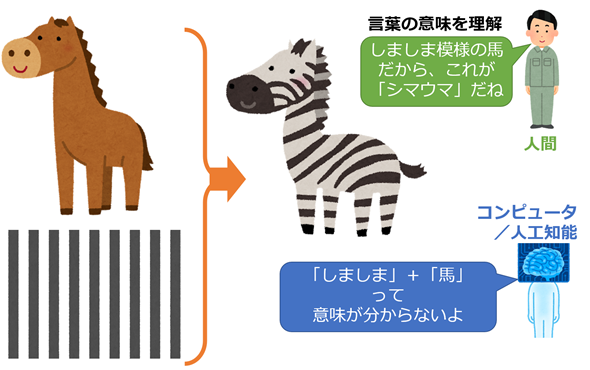

シンボルグラウンディング問題(Symbol grounding problem)とは、「記号(シンボル)つまり文字列や言葉が、実世界の意味とどのように結び付いているのか(=グラウンディング)」を問う問題です。

人間は「言葉」を「自らの経験や知覚」と結び付けて理解します。しかしAIは、そうした実体験の裏付けなしに記号を扱っているため、「意味を理解している」とは言い難い、という主張です(図2)。特にかつてのルールベースや知識表現ベースの人工知能では、「記号と意味が切り離されたまま処理されている」という批判がありました。

現在は、ChatGPTなどの生成AIが登場し、「AIが言葉の意味を理解しているかのように感じる場面」が増えてきました。生成AIは、大量のテキストから統計的にパターンを学び、「もっともらしい応答」を出力します。それが、あたかも“意味が分かっている”ように見えるのです。こうした仕組みによって、シンボルグラウンディング問題の解決に一歩近づいたという見方もあります。

しかし実際には、現在の生成AIが「経験」や「身体」を通して言葉の意味を理解しているわけではありません。人間のような意味理解には、依然として身体性(=体験を通じて得られる知覚)や文脈理解が不可欠ではないでしょうか。AIの進化は急速に進んでいるため、近いうちに完全に解決できる可能性もあるかもしれませんが、この問題は今後もAIを考える上で欠かせないテーマであり続けると筆者は考えます。

2. フレーム問題

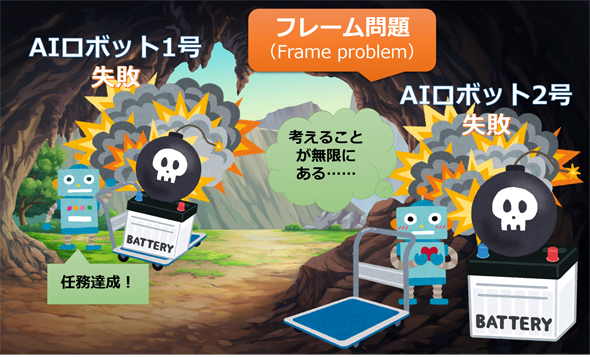

フレーム問題(Frame problem)とは、AI(ロボット)が課題を実行する際に「どこからどこまでを考えればいいか」という枠組み(=フレーム)を適切に設定する難しさを示す用語です。現実にAIが動作する環境では、無数の予想外の出来事が起こり得ます。

例えば、AIロボットに「洞窟内にあるバッテリーを取ってきなさい」と指示したとき、時限爆弾が載ったバッテリーをそのまま運べば爆発に巻き込まれるでしょう(図3の「1号」)。一方、「時限爆弾を外そうとすると、天井が落ちてくるかも」「壁の色が変わるかも」といった無関係なことまで次々と検討し始め、結局、時限爆弾の爆発に巻き込まれる可能性があります(図3の「2号」)。

人間は経験から「これは考えなくていい」と自然に切り捨てられますが、AIにはそれができません。このように「課題に関係することだけに絞ることがいかに難しいか」が、フレーム問題です。

現在のAIは、学習済みデータに基づいて応答するため、一見すると無限に考え込むことはありませんが、それはあくまで「与えられた前提や目的に沿って計算しているから」です。そのため「空から魚が降ってきて車のフロントガラスに直撃する」という予想外の事象に遭遇した場合、現状の自動運転は緊急停止や回避といった限定的な対処はできても、人間のようにその場で「今どこに注意を向け、どこまで考えればよいか」という枠そのものを柔軟に見直すことはできないと考えられます。最近はエージェント型AIが計画を立てて行動する仕組みもありますが、それも結局は「未知の状況に応じて、その場で柔軟に枠組みを再構築している」わけではありません。その意味で、フレーム問題は今もなお課題として残り続けています。

3. トロッコ問題

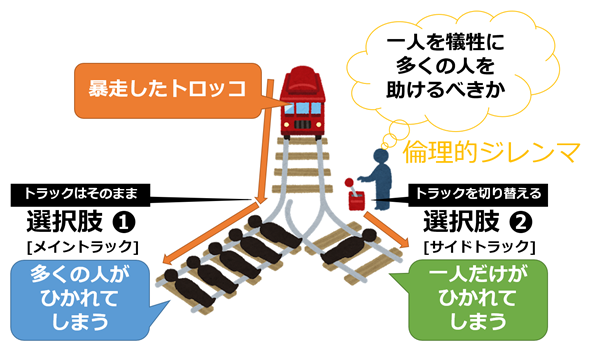

トロッコ問題(Trolley problem)とは、「多くの人を助けるためなら、1人を犠牲にしてもよいのか」という倫理的ジレンマを問う思考実験です。

具体的には、暴走するトロッコ(路面電車)が、線路上に縛られて動けない5人に向かっています(図4のメイントラック)。あなたは分岐レバーの前に立っていますが、切り替え先のサイドトラックにも1人が縛られていて、やはり逃げられません(図4のサイドトラック)。このときに取れる選択肢は以下の2つです。

- 選択肢(1)[メイントラック]: 何もせず、5人がひき殺される(傍観者)

- 選択肢(2)[サイドトラック]: レバーを引いて、1人だけがひき殺される

「どちらがより倫理的な選択となるか」について一人一人の価値観が問われますが、正解はありません。多くの調査では、およそ90%が「1人を犠牲にして5人を助ける」という選択肢(2)を選びます。助かる命が多いことに重点が置かれているわけですが、それでもなお「能動的に誰かを犠牲にすることは本当に倫理的と言えるか?」という問いが残ります。

近年、このトロッコ問題は自動運転や医療AIなど、人命に関わる分野で再び注目されています。AIにどんな判断を任せるべきか。この問題は、テクノロジーと向き合う私たち一人一人に突き付けられているテーマです。

4. ブラックボックス問題

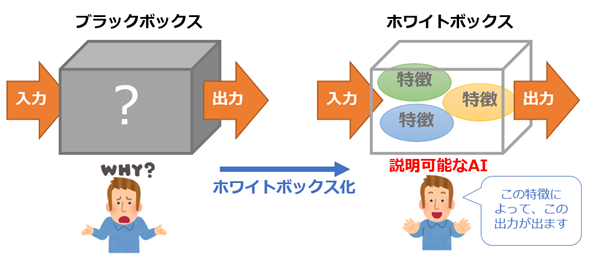

ブラックボックス問題(Black-box problem)とは、(特にニューラルネットワークなどの)AIモデルの出力が「どのように導かれたのか」が人間には分からない、という課題です。

AIは大量のデータから複雑なパターンを学習しますが、その内部は極めて複雑に入り組んでいるので、人間には解釈が難しく、まさに中身が見えない「ブラックボックス」となっています。そのため、社会に導入する場面では「中身が説明できないものは安心して使えない」という懸念が生じやすいのです。例えば自動運転で事故が起きたとき、原因が究明できなければ責任や安全性が問えないと考えられます。こうした理由から、最終的にAIの採用が見送られることも考えられます。

そのため近年では、ブラックボックス問題を解消する「ホワイトボックス化」、いわゆる「説明可能なAI(XAI)」に注目が集まっています(図5)。「どの入力が、どんな出力に、どのように影響したか」といった根拠を明らかにする研究が活発に進められており、実際にSHAPなど広く使われる手法も登場しています。

さらに最近では、生成AIの登場にAIモデルはより複雑になり、その内部を解釈することはますます困難となっています。例えばChatGPTなどのチャットAIでは、事実とは異なる回答が生成されるハルシネーションが頻繁に起こりますが、その原因は完全には解明されていません。このように、AIの高度化に伴いブラックボックス問題はますます深刻な課題となっています。現在もXAIなどの技術開発と研究は進められているものの、根本的な解決には長い時間がかかるか、あるいは最終的に完全には解決されない可能性さえあるでしょう。

5. コールドスタート問題

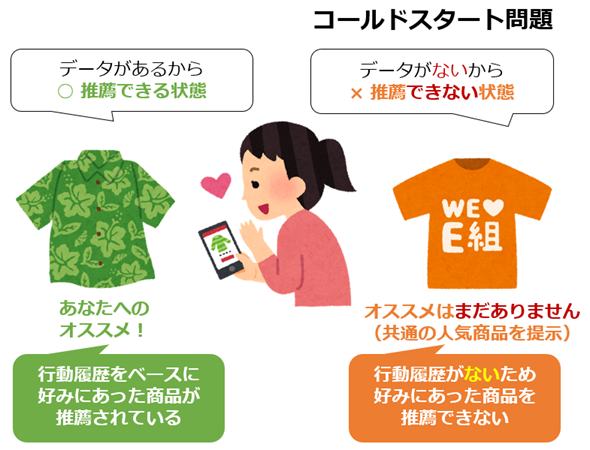

コールドスタート問題(Cold start problem)とは、レコメンデーション(推薦)や予測を行うAIシステムにおいて、ユーザーや商品アイテムに関する初期データが不足しているために、適切な推薦や予測ができない状況を指す用語です。

特に推薦システムは通常、過去の行動履歴や商品の属性データなどからパターンを学習します。そのため新規ユーザーや新商品、新サービス開始直後のようにデータがほとんどない場面では、例えば「新規ユーザーの好みは分からない(図6)」「新商品はどんな人に響くかが分からない」といった問題が現れて、推薦システムの性能が著しく低下してしまいます。

このようなコールドスタート問題への対策としては、「初期登録時にアンケートを取る」「商品の特徴や人気度などあらかじめ分かっている情報に基づいて推薦する」といった工夫が行われます。また近年は、画像認識や生成AIといった技術により商品アイテムそのものから特徴を抽出する手法や、他分野で学習済みのモデルを応用する手法も取れるようになってきました。

こうした取り組みによって、コールドスタート問題は少しずつ緩和されつつあります。とはいえ、根本的な原因は初期データが存在しないことにあるため、完全に取り除くことはほぼ不可能です。そのため、今後も推薦や予測における重要な課題であり続けるでしょう。

以上、AIに関わる代表的な“○○問題”を5つご紹介しました。これらは、単なる技術上の課題にとどまらず、AIの特性や社会との関わり方そのものを考えさせるテーマでもあります。本稿が、AIへの理解をさらに深め、今後の活用や議論において本質を見据えるヒントとなれば幸いです。

Copyright© Digital Advantage Corp. All Rights Reserved.