「AIと言えばGPU」一択ではない CPUでAIが動く時代のサーバインフラ:DXを成功させるカギはコストと性能のバランス

AI活用が広がり、「AIと言えばGPU」という認識も生まれる中で、これからのサーバインフラの在り方はどう変わるのか。インテルが新世代プロセッサとともに提供する新たな選択肢とは。

AI基盤にもクラウド/オンプレミスの選択肢

企業のサーバインフラに求められる要件は、生成AI活用、アプリケーションの多様化、コストの最適化、セキュリティ対策の強化といったニーズが高まる中で変化しつつある。例えばAIで必要とされるGPUなどの高性能な環境はコストがかさむため、コンピューティング性能とコストのバランスをどう取るべきかが悩ましい問題だ。CPUの進化も著しく、大量のデータ処理が求められる生成AIの稼働環境でさえ、クラウド上のGPUだけではなくオンプレミスのCPUサーバで稼働させるという選択肢が登場している。

要件と選択肢が多様化する中で、これからのサーバインフラをどう構築すべきか。2025年6月27日に開催されたオンラインセミナー「生成AIでのDX本格化を支える サーバインフラのあり方とは」からヒントを探る。

生成AIの“ショック期”に企業がすべきこと

基調講演に登壇したアイ・ティ・アール シニア・アナリストの入谷光浩氏は、生成AIやAI/機械学習プラットフォームを中心にIT投資が活発化している現状と、企業がとるべき戦略について語った。同氏は、生成AIを手軽に利用できるサービスが増えて幅広い業務で活用が進む一方、ビジネス価値創造へとつなげるためには、サービスの「利用」から、業務フローに組み込む「構築」、RAG(検索拡張生成)など自社に合わせた「作り込み」、独自LLM(大規模言語モデル)の「開発」へと段階的に進める必要があると指摘する。

「現在、生成AIは初期の高揚感が失われた“ショック期”にありますが、今後の本格的な回復期に備えて今のうちにAI活用の基盤を整えるべきです」(入谷氏)

さらに入谷氏は「これまでAI環境はクラウド環境での構築が主流でしたが、オンプレミスを検討する企業も増えています」と語り、パフォーマンスやコスト、セキュリティ、拡張性などそれぞれの特長を踏まえて自社の要件にあわせて検討する必要があること、クラウドとオンプレミス両方の選択肢を持つことの重要性を強調した。

AIインフラにも活用できる最新CPU

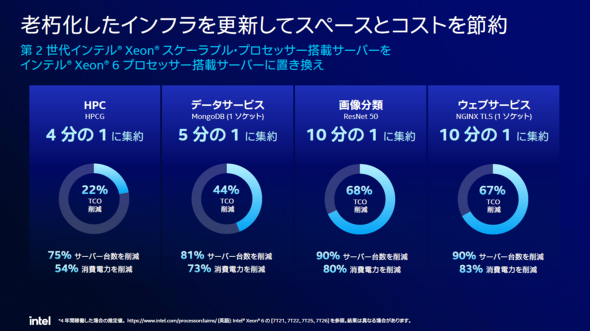

AIインフラを考える際に意識したいのがCPUの進化だ。性能や電力効率が大幅に向上しており、CPUベースでAIインフラを構築することも現実的な選択肢となっている。最新世代のCPUに置き換えるだけでも、かなりのTCO(総所有コスト)削減が期待できる。具体的にどこまで変わるのか、インテル インダストリー事業本部 シニア・ソリューション・アーキテクトの高藤良史氏のセッションを中心に紹介しよう。

高藤氏は、コスト削減や電力効率の向上、スループット向上などデータセンターの課題に応えるべく、インテルのCPUは進化を進めてきたと説明。その成果として挙げたのが最新世代の「インテル® Xeon® 6 プロセッサー」(以下、Xeon® 6)だ。AIやスーパーコンピュータ、データベース分析、ネットワーク、コンテンツ配信など幅広いワークロードに対応し、前世代よりも格段にパフォーマンスを向上させている。データの信頼性と安全性を守る機能の他、AIアクセラレーターを内蔵している点が特長だ。Xeon® 6を1世代前と比較すると、同じコア数で20〜50%ほどパフォーマンスを向上させている。

Xeon® 6は汎用(はんよう)的なエンタープライズ用途に適した「Pコア」(Performance-cores)と、消費電力を抑えた「Eコア」(Efficient-cores)の2種類を展開している。Eコアはコアの構成をシンプルにすることで集約率を高めており、マイクロサービスアーキテクチャやWeb系の大規模ソフトウェア環境などに適している。

高藤氏は「メディアストリーム処理の環境において、『第2世代インテル® Xeon® スケーラブル・プロセッサー』では200ラック必要だったものが、Xeon® 6 Eコアでは、約66ラックと3分の1にまで削減できます。集約率が高まれば冷却効率も上がり、消費電力やCO2排出量の削減にもつながります」と説明する。

第2世代インテル® Xeon® スケーラブル・プロセッサーは2019年にリリースされた。当時導入したサーバをXeon® 6に切り替えただけで、TCOを20〜70%削減できた試算もあるという。サーバ更改においては従来と同じコア数のサーバを検討する傾向が強いが、コア数の多いサーバは導入コストこそ高くなるものの、集約率が高まることでスペースや消費電力、そしてそれらにかかるコストを削減できる。CPU選定についても、TCOを含めた長期的な視点で検討する必要がある。

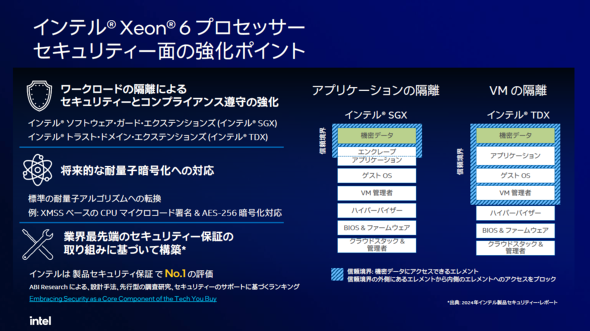

CPUレベルでもセキュリティを強化

サイバー攻撃の手口が巧妙化する今、AIが活用するデータやAIモデルそのものをいかに保護するかも重要な課題だ。Xeon® 6はそうした状況に対応できるよう、セキュリティ対策も大幅に強化されている。

「インテル® SGX」 (Software Guard Extensions)、「インテル® TDX」 (Trust Domain Extensions)という2つの技術を搭載。ハードウェアに内蔵された暗号化機能により、他のアプリケーションや仮想マシンからデータを隔離、保護し、機密データへの不正アクセスを防ぐ。「最近は量子コンピューティングが注目されていますが、インテルはその動向も見据えて耐量子暗号化への対応も視野にセキュリティを強化しています」と高藤氏は説明する。

AIをより手軽に使える世界へ

高藤氏がセッションで度々言及したのが、インテルが掲げる「AI Everywhere」というコンセプトだ。「AI=GPUという認識を取り払い、CPUでもAIが手軽に動作する世界を実現できれば、AIの活用の幅が広がるはずです」。AIというと最近はLLMや生成AIのイメージが強いが、ビジネスの現場を見ると画像認識や画像分類の需要もいまだに根強い。こういった軽量なAI処理ではもはやGPUを使う必然性は薄れつつあると高藤氏は指摘する。その中でインテルが提案するのが、CPUでAI関連のタスクを処理するアプローチだ。

高藤氏はデータセンター向けAI製品としても、GPUではなくXeon® 6を挙げる。AIアクセラレーター「インテル® AMX」 (Advanced Matrix Extensions)を搭載しており、小規模なLLMであれば十分に実行可能だ。そして、700億パラメーター以上のより大規模なモデルに適しているのが、「インテル® Gaudi® 3 AIアクセラレーター」だ。

では、GPUとAIアクセラレーターの違いはどこにあるのか。「GPUはHPC(ハイパフォーマンスコンピューティング)などでの利用が想定されており、倍精度浮動小数点など高精度の演算ができます。しかし、AIは比較的低精度で多くのパラメーターを保持する必要があり、高精度演算は必ずしも必要ではありません。そこで、これらの機能を排除し、AI処理に特化させたのがAIアクセラレーターです」(高藤氏)

「RAG」の検索や、推論実行もCPUで対応可能に

CPUベースでのAI活用で、特に注目したいのがRAGだ。生成AIモデルのパラメーターが増加して、複雑な処理をするにはモデルサイズの肥大化は避けられない。かといって、企業ごとに大規模モデルをトレーニングするのは現実的ではない。そこでRAGを使い、企業が保有するデータセットを事前にベクトル化し、ユーザーの質問に近い情報を検索、参照して回答を生成することで回答精度を高める。

RAGの仕組みにおいて、ベクトルデータベースへの問い合わせなどはXeon® 6で対応可能だ。「RAGのレスポンスタイムにはプロセッサが大きく関わります。例えば、チャットサービスのやりとりではレスポンスタイムがシビアに問われますが、このような領域でのデータ検索にXeon® 6は有効です」

従来のCPUではベクトル検索の処理性能を十分に引き出すのが難しい課題があったが、Xeon® 6はAI処理高速化技術である「インテル® AMX」を組み合わせることで、RAGにおけるベクトル検索をより効率的に実行することを可能にする。「インテル AMXはCPUコアに内蔵されたアクセラレーターです。コア数が多ければ、それだけ多くのインテル AMXを持つことになります。つまりコア数が多いCPUを利用することで、用途によってはGPUを使わなくても効率的な推論が可能になります」

実際に、インテルはXeon® 6とRAGを使い、監視カメラの映像を検索する実験をしている。ユーザーが動画に「不審な人がいたか」といった問い合わせをすると、RAGが動画ログを見た上でベクトルデータベースを検索し、LLMに結果を返す。その結果を基にLLMがユーザーへの回答を生成するというものだ。

AI処理でGPUが必要とされるのは主に学習のフェーズだ。推論を実行するだけならばGPUは必要ない場合も多い。となれば、環境への要件も変わってくる。精度が高く商業利用可能なモデルが多く登場する今、推論処理だけを実行したいというケースもあるだろう。その際、GPUほどコストをかけず、CPUでAIインフラを構築するというアプローチは魅力的だ。

コストパフォーマンスに優れたAIアクセラレーター

インテル® Gaudi® 3 AIアクセラレーターは、1台のサーバノードに最大8基搭載できるユニバーサルベースボードの他、PCIeカードでも提供している。128GBのHBM2Eメモリを搭載し、1678T(テラ)FLOPSという高いパフォーマンスを発揮する。

「インテル® Gaudi® 3 AIアクセラレーターはIBM Cloudでも採用されています。IBMのAIモデルGranite 3.1 8bモデルでは25〜40%ものコスト効率化を実現しました。コストとパフォーマンスのバランスが良い製品だと言えるでしょう。PCIeタイプもAIアクセラレーターの選択肢の一つとしてご検討いただきたいです」

最後に高藤氏は、製品のオープン性に触れて次のように締めくくった。「特定のベンダーだけがAIビジネスに関わるのではなく、多様な企業がAIをより手軽に活用できる製品を提供することで、AIの民主化が進むとインテルは考えています。そのためにも、AIのオープン・エコシステムを活用することが重要であり、インテルの製品はその理念に基づいています」

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:インテル株式会社

アイティメディア営業企画/制作:@IT 編集部/掲載内容有効期限:2025年8月11日

インテルの高藤良史氏

インテルの高藤良史氏